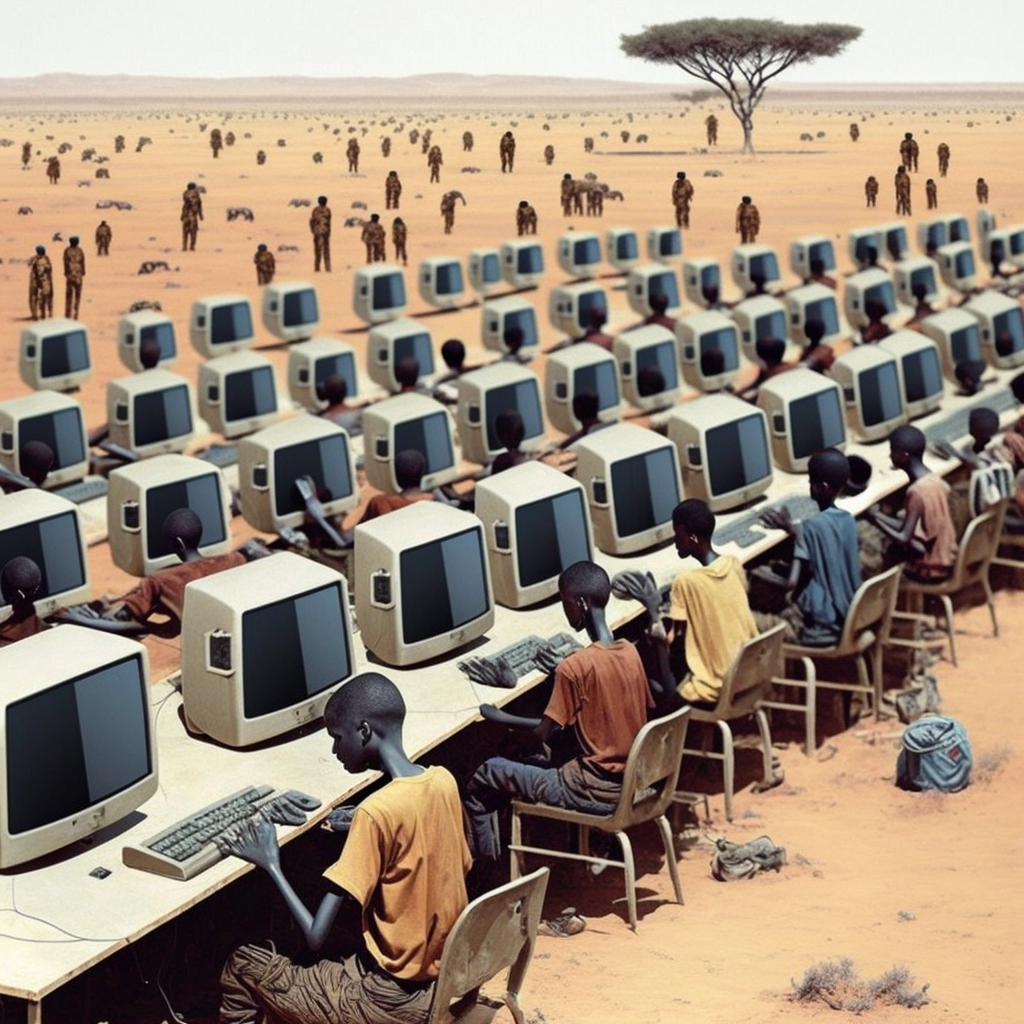

Tania siła robocza z Kenii, za mniej niż dwa dolary za godzinę, uczy sztuczną intelegencję, w jaki sposób unikać toksycznych treści.

Sztuczna inteligencja ma tendencję do naśladowania ludzkich uprzedzeń. Aby temu zapobiec, Open AI ucieka się do wykorzystywania taniej siły roboczej.

Jednym z centralnych problemów rozwoju sztucznej inteligencji jest zapobieganie powielaniu wszelkiego rodzaju „myślozbrodni”, czyli poglądów niezgodnych z aktualnymi (i dynamicznie zmieniającymi się) standardami politycznej poprawności, które ku zmartwieniu gremiów (mylnie nazywanych liberalnymi) wciąż jeszcze często pojawiają się w internecie, czyli w materiale na jakim szkolona jest sztuczna inteligencja.

Ten problem pojawia się ogólnie we wszystkich formach uczenia maszynowego, ale jest szczególnie groźny w dużych modelach językowych (LLM large language models), takich jak GPT-3, na którym opiera się Chat GPT.

Czynnik ludzki

W przypadku Chat GPT odpowiedzią na ten problem są ludzie. Ludzie, którzy ręcznie uczą AI, co jest odpowiednią politycznie poprawną, a co nie. W ten sposób AI stopniowo uczy się, co jest właściwym zachowaniem. I rzeczywiście, w przeciwieństwie do wielu swoich poprzedników, chatbot Open AI nie jest skłonny do rasistowskich czy seksistowskich wypowiedzi (sprawdzałem, ChatGPT jest w tym zakresie bardziej pryncypialny niż PC Principal z South Park 🙂 ).

Cieszy to liberalne serca, ale ma też swoją ciemną stronę, którą ujawnił teraz raport gazety Time. Szkolenie Chat GPT przeprowadza podobno kenijska firma Sama, której pracownicy otrzymywali mniej niż dwa dolary za godzinę pracy.

Problematyczne treści

W przypadku Chat GPT podobno szkolenie odbywa się w taki sposób, że sztuczna inteligencja została nauczona, czym są toksyczne treści. Konkretnie oznacza to, że pracownicy ręcznie oznaczają wszystkie te treści odpowiednimi etykietami, które następnie AI wykorzystuje do stopniowego uczenia się, jakie treści powinna odfiltrować.

W tym celu, od listopada 2021 roku wysłano do rzeczonej firmy dziesiątki tysięcy podejrzanych, negatywnych przykładów pytań i odpowiedzi z ChatGPT. Według raportu Time zawierały one opisy morderstw, tortur i przemocy seksualnej.

Stanowisko Open AI

Open AI wcale nie zaprzecza relacji gazety, ale widzi to wszystko jako niezbędny etap w rozwoju sztucznej inteligencji. „Klasyfikacja i filtrowanie szkodliwych treści jest niezbędnym krokiem do zminimalizowania agresywnych i seksualnych treści w danych treningowych, a także do opracowania narzędzi, które mogą wykryć takie zjawiska” – piszą w swoim oświadczeniu.

W rzeczywistości taka praktyka nie jest rzadkością. Firma Sama, o której mowa, jest również wykorzystywana przez innych dużych producentów oprogramowania, takich jak Google, Meta i Microsoft, do szkolenia sztucznej inteligencji. Reklamuje się nawet jako „etyczna firma AI”, która pomogła do tej pory 50 tys. Kenijczyków wyjść z ubóstwa.

Ale raport Time pokazuje również, że sami pracownicy nie zawsze widzą to w ten sposób. Skarżą się na przykład, że praca jest bardzo traumatyczna i że pewnych brutalnych opisów nie mogą już usunąć z głowy.

Outsourcing tego, co nieprzyjemne

To nie pierwszy raz, kiedy Sama trafia na nagłówki gazet. Równo rok temu Time określił kenijską firmę jako „afrykański sweatshop Facebooka” (Sweatshop to termin określający fabryki, zazwyczaj w krajach rozwijających się, w których ludzie pracują za niskie wynagrodzenie.). Firma przejęła też część moderacji treści dla Mety, a za pensję w wysokości około 1,50 dolara za godzinę, pracownicy muszą patrzeć na wszelkie czarne otchłanie człowieczeństwa. Należą do nich także wykorzystywanie seksualne dzieci i egzekucje.